Lexum s’est toujours consacré à utiliser les dernières technologies pour diffuser le droit dans le but d’améliorer le rapport coût/bénéfice de l’accès à l’information juridique. Pour cette raison, nous avons historiquement privilégié les moteurs de recherche plein texte aux systèmes de classification basés sur des thésaurus. L’étiquetage manuel des décisions judiciaires et administratives est un processus exigeant beaucoup de main-d’œuvre qui a traditionnellement contribué aux coûts élevés de l’édition juridique. Lorsque de grands volumes de décisions sont rendues, cela limite également une publication exhaustive, justifiant la sélection d’un nombre limité de « décisions rapportées ». Lexum a toujours foncé directement dans la direction opposée.

Néanmoins, une fois que vous commencez à publier plusieurs centaines de milliers de décisions chaque année et que vous vous retrouvez avec des bases de données de millions de documents, le besoin d’une certaine forme de catégorisation des données ne cesse de refaire surface. Même s’ils sont équipés d’un moteur de recherche en texte intégral de pointe, les usagers doivent faire face à de grands volumes de résultats pour presque toutes leurs requêtes. Ils demandent à juste titre des outils les aidant à filtrer les documents non pertinents, et catégoriser la jurisprudence par domaines de droit ou sujets est la méthode la plus évidente qui vient à l’esprit. Mais comment répondre à ce besoin sans lire ou analyser chaque jugement?

Il y a environ 10 ans, Marc-André Morissette, VP Technologie chez Lexum, a eu l’idée d’utiliser une approche statistique pour distinguer les mots-clés qui sont utilisés de manière répétitive dans un document tout en étant proportionnellement moins fréquents dans le reste de la base de données. D’un côté, cette approche a l’avantage d’être basée sur des algorithmes statistiques disponibles dans la communauté du logiciel libre et de faciliter le balisage des décisions parmi de longues listes de résultats de recherche. D’un autre côté, elle a tendance à privilégier les mots-clés factuels car les concepts juridiques se retrouvent dans de nombreux cas similaires. Puisque ces mots-clés factuels varient considérablement, ils sont inadéquats pour alimenter un filtre de recherche par sujets dans l’ensemble de la base de données.

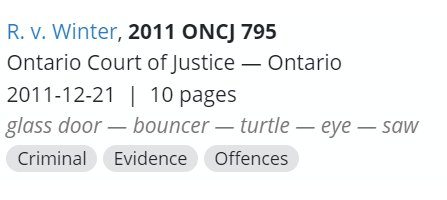

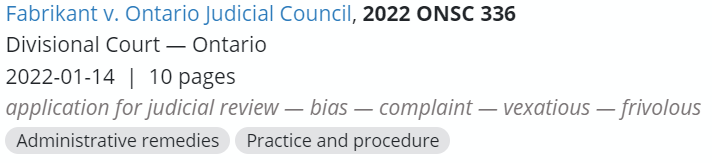

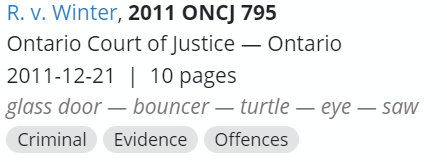

La plupart du temps, les mots clés générés statistiquement fournissent des informations utiles :

Mais dans certains cas, ils constituent des indices mystiques donnant très peu d’indications sur ce qui est réellement en jeu :

Et c’est sans mentionner toutes les insultes innovantes provenant des citations de témoignages qui se glissaient systématiquement dans les listes des mots-clés. Des efforts substantiels ont dû être investis pour les exclure et éviter que la fonctionnalité ne soit perçue comme un générateur d’insultes…

Tout cela mène à la conclusion que si l’extraction automatisée de mots-clés de la jurisprudence par une approche statistique était une évolution positive à l’époque, elle se heurte également à de sérieuses limites. Pour cette raison, les développements récents dans le domaine de l’intelligence artificielle ont été perçus par Lexum comme une opportunité de revoir sa technique de classification automatique de la jurisprudence.

Depuis plusieurs années, Lexum investit des efforts considérables dans le développement de capacité en intelligence artificielle (IA) dédiées au traitement de l’information juridique. Cela a mené à plusieurs projets de R&D, dont un axé sur le développement d’un algorithme de prédiction de citations juridiques. Mais la classification par sujets générés par l’IA pour la jurisprudence de la Saskatchewan annoncée par CanLII en juin 2021 est devenue le premier résultat concret de ces efforts déployés dans un environnement de production. En janvier de cette année, la même technique a été appliquée à la jurisprudence ontarienne.

Pour rendre ces projets possibles, Lexum a utilisé des algorithmes d’apprentissage profond, qui sont un sous-ensemble d’algorithmes d’apprentissage automatique permettant à un ordinateur « d’auto-programmer » un modèle (un ensemble d’équations mathématiques apparentées à du code informatique) pour accomplir une tâche complexe en apprenant d’un ensemble d’exemples. Pendant la phase d’apprentissage, ces algorithmes reçoivent à la fois les données d’entrée et la sortie souhaitée, puis ils ajustent lentement la programmation du modèle dans le but d’accomplir la tâche souhaitée. Plus tard, pendant la phase d’inférence, ce modèle est appliqué à des données inconnues afin de produire ce que l’on pense être la sortie souhaitée. Dans le cas du projet actuel, l’entrée est le texte d’une décision de justice canadienne et la sortie est l’ensemble des sujets associés.

Pour la phase d’apprentissage, Lexum a traité (sous autorisation) des milliers de décisions ayant déjà été classés par la Law Society of Saskatchewan Legal Resources Library (via leur base de données digests database) et le Barreau de l’Ontario (via les Ontario Reports). Les sujets et autres informations textuelles (non structurées) présents dans les documents ont été systématiquement étiquetés afin qu’ils puissent être soumis à l’algorithme d’apprentissage de façon uniforme. Lexum a créé une taxonomie de 42 sujets (ou domaine de droit) qui ont ensuite été mis en correspondance avec les centaines de mots-clefs des données d’entraînement. Le Longformer Deep Learning Model1, qui est une solution de pointe en matière d’apprentissage profond pour les longs documents, a été utilisé pour créer le modèle de classification. Ce modèle a été sélectionné après avoir expérimenté avec de nombreux autres modèles d’apprentissage et après une optimisation approfondie des hyperparamètres pour maximiser la précision et le rappel. À cette étape, en plus des tests automatisés, les résultats ont été examinés par des chercheurs juridiques expérimentés afin de déterminer si les sujets attribués automatiquement sont adéquats et corrects.

Les sujets générés par l’IA qui en résultent sont actuellement affichés sur les pages de résultats de recherche de CanLII, juste en dessous des anciens mots-clés générés statistiquement.

L’utilisation d’une taxonomie normalisée a permis l’introduction d’un nouveau filtre de recherche « Par sujet » pour les deux juridictions prises en charge jusqu’à présent. Voici un exemple de décisions ontariennes filtrées avec le sujet indigenous peoples. À l’avenir, nous prévoyons d’ajouter des hyperliens à ces étiquettes de sujet pour faciliter l’affinement des requêtes de recherche.

Lexum progresse actuellement vers le déploiement de son nouveau modèle de classification alimenté par l’IA dans l’ensemble de la base de données de CanLII de près de 3 millions de décisions. Mais avant d’en arriver là, quelques défis restent à relever :

- Incohérence entre les juridictions : Le modèle actuel imite les politiques éditoriales distinctes des auteurs ayant produit chaque ensemble de données. Fournir des résultats cohérents dans toutes les juridictions nécessite des ajustements supplémentaires.

- Les documents juridiques sont trop longs : la plupart des transformateurs pré entrainés existants sont limités à des documents de 500 mots maximum, et celui qu’utilise Lexum prend en charge jusqu’à 4 000 mots.

- Pas de prise en charge des documents en français : le modèle actuel ne fonctionne qu’en anglais.

- Préjugé envers les sujets généralement trouvés dans les recueils de jurisprudence : La qualité des sujets générés pour les décisions qui ne sont généralement pas rapportées (par exemple, CanLII héberge de nombreuses décisions de petites créances) est inférieure.

- Performances inférieures dans les juridictions sans données d’entrainement : lorsqu’on lui présente des décisions provenant d’autres juridictions, le modèle de classification ne peut produire que des sujets appropriés pour les juridictions auxquelles il a été exposé.

- Manque de matériel d’entrainement: c’est typique de la plupart des projets d’apprentissage automatique. Pour améliorer le modèle, des ensembles de données d’entrainement supplémentaires provenant de l’extérieur de CanLII doivent être identifiés.

Ces défis ne sont pas anodins, mais notre équipe a une vision pour relever chacun d’entre eux. Avec le bon mélange de choix avisés, de persévérance et comme d’habitude un peu de chance, il devrait éventuellement être possible pour les utilisateurs de CanLII de filtrer n’importe quelle requête de recherche par sujet. Peut-être même lire un court résumé généré par l’IA pour chaque décision, mais cette histoire est pour un autre article de blog…